近日,号称史上最强大的开源模型——Meta Llama 3 正式发布。伴随着日新月异的模型生态,腾讯云异构计算平台作为覆盖90%+大模型客户的AI底座,现已做好充足的准备,围绕Llama 3系列模型,提供从基础设施到编排调度的智算产品矩阵,为企业及开发者提供更快部署、更强性能和更高吞吐的全链路解决方案。

一、更快部署 通过 HAI 创建 Llama 3 仅需 3 分钟

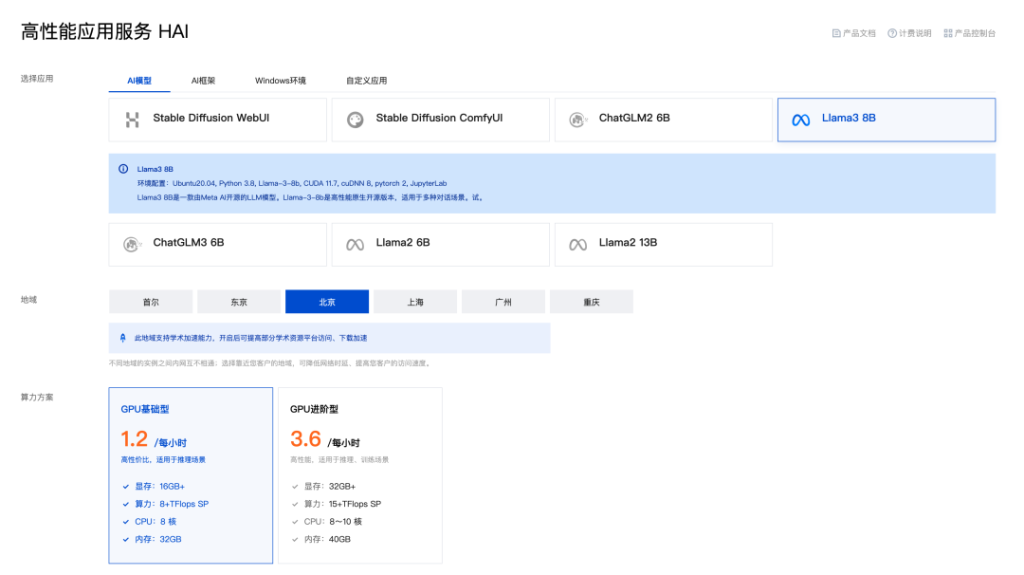

随着大模型时代的到来,应用有望生长出更大价值。如何取得先发优势、优质的模型能力是构建AI应用核心竞争力的关键。为了解决中小企业及开发者在AI应用上担心的敏捷部署、成本效益、数据安全等难题,我们推出了全新的即插即用的 GPU 应用服务产品——高性能应用服务 HAI 。不仅提供即插即用的便捷性,还支持 AI 模型在云端的私有化部署,确保在有丰富模型选择的同时,数据安全也能得到严格保护。

在 Meta 发布 Llama 3 后,腾讯云 HAI 第一时间支持了 Llama 3 的一键部署。通过 HAI 仅需 3 分钟,中小企业及开发者可以轻松实现基于 Llama 3 的应用创作与开发,将其应用于各种场景,如智能客服、内容创作、文本分析等,提升产品竞争力或企业运营效率。

腾讯云 HAI 提供一键即得的澎湃算力与常见环境,助力中小企业及开发者快速部署 LLM、AI 作画、数据科学等高性能应用,原生集成配套的开发工具与组件,大幅提高应用层的开发生产效率。此前已支持 ChatGLM 系列、Stable Diffusion、Llama 2 等丰富主流模型,同时支持 Notebook、WebUI 等多种图形化算力交互模式,以应用为核心降低云原生 AI 应用落地门槛。

二、更强性能 全新实例 Llama 3 推理性能提高 2-10 倍

在硬件层面,腾讯云推出的最新一代异构计算 GPU 实例 PNV5b,围绕 Llama 3 等大模型场景,将AI推理部署性价比提升至新的高度。

Llama 3的模型特点与 Llama 2 十分类似,支持 GQA 机制降低大模型推理过程中的 KV cache 显存开销。PNV5b实例采用最新一代 GPU,单卡搭配 48GB 显存,在算力和显存匹配上做到了更好的平衡,为大模型推理提供了更优的性价比。同时,PNV5b 实例在整机架构设计上支持最大单机 8 颗 GPU 高效扩展,大幅提升分布式推理性能。

在 Llama 3 的推理部署测试中,在典型业务请求压力条件下,PNV5b 的推理吞吐对比上一代 PNV4 可提升 2-3 倍;而在极端请求压力测试下,性能可进一步提升至 10 倍。这意味着,PNV5b 实例能提供更好的性能扩展能力,让用户在面对大模型的业务洪峰时更加游刃有余。

除此之外,PNV5b 通过星星海服务器搭配最新一代 AMD CPU 平台,提供多种实例规格,可灵活匹配大模型推理、大模型精调、推荐系统等多种场景的实例规格需求。将为广大用户带来更贴合业务的AI模型训练和推理体验,为企业和开发者创造更多的价值。

美国服务器

(本文由服务器总代理原创,转载请注明出处“服务器总代理”和原文地址!)

服务器购买/咨询热线:15637009171或15617636856

本文链接:http://www.sqxnmj.com/jishuzhichiyuweihu/199064.html